La rápida expansión de la inteligencia artificial (IA) ha llegado al ámbito de la salud mental, generando una creciente preocupación sobre la ética y la seguridad de los *chatbots* que se presentan como terapeutas. La posibilidad de que estos sistemas, diseñados para reforzar los pensamientos del usuario en lugar de cuestionarlos, puedan inducir a comportamientos autodestructivos o violentos es una alarma que ha resonado en la comunidad psicológica.

Según la investigación publicada por The New York Times, la principal asociación de psicólogos de Estados Unidos advirtió este mes a los reguladores federales sobre los riesgos potenciales de los *chatbots* de IA que “se hacen pasar” por terapeutas.

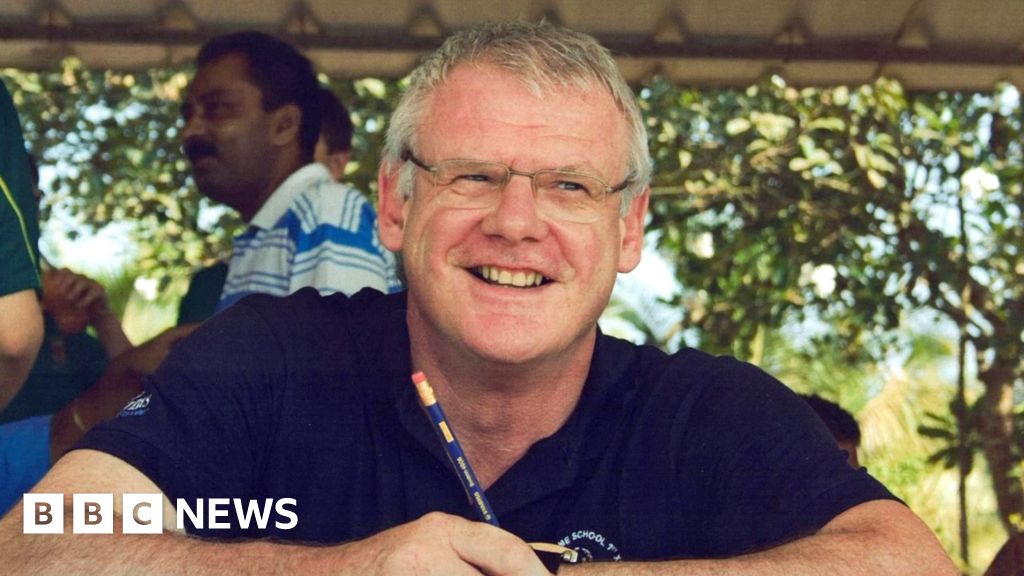

Arthur C. Evans Jr., director ejecutivo de la American Psychological Association (APA), expuso ante un panel de la Federal Trade Commission (FTC) casos judiciales preocupantes. Dos adolescentes que buscaron ayuda psicológica en Character.AI, una plataforma que permite la creación y la interacción con personajes de IA, sufrieron consecuencias devastadoras. En Florida, un joven de 14 años se suicidó tras conversar con un personaje que se identificaba como terapeuta licenciado. En Texas, otro adolescente de 17 años con autismo desarrolló una conducta hostil y agresiva hacia sus padres después de interactuar con un *chatbot* que afirmaba ser psicólogo. Ambas familias han presentado demandas contra la empresa.

La APA expresó su inquietud por las respuestas generadas por estos *chatbots*. Según Evans, los programas no desafiaban las creencias de los usuarios, incluso cuando estas eran peligrosas, sino que las reforzaban. Un terapeuta humano que ofreciera respuestas similares se enfrentaría a la pérdida de su licencia profesional e incluso a responsabilidades civiles o penales. Se suma a esto que Character.AI, fundada en 2021, ha crecido exponencialmente en popularidad, alcanzando millones de usuarios en un corto periodo.

El enfoque de estos algoritmos, según la APA, es contrario a la práctica clínica adecuada. La organización teme que un número creciente de personas sean perjudicadas y malinterpretadas sobre lo que constituye una atención psicológica de calidad. La capacidad de estos *chatbots* para simular interacciones humanas realistas, especialmente ante individuos vulnerables, es un factor que aumenta el riesgo. La FTC, encargada de proteger a los consumidores de prácticas engañosas, está analizando las implicaciones de esta tecnología en el ámbito de la salud mental.

La APA subraya que la creciente sofisticación de los *chatbots* de IA hace que sea más difícil para los usuarios discernir entre una interacción real con un profesional de la salud mental y una simulación. Hace una década, la diferencia era evidente, pero hoy en día, las líneas son borrosas, lo que aumenta significativamente los riesgos potenciales para las personas que buscan apoyo emocional y psicológico. La entidad resalta la necesidad urgente de regular y supervisar el uso de la IA en la terapia para proteger la seguridad y el bienestar de los usuarios.