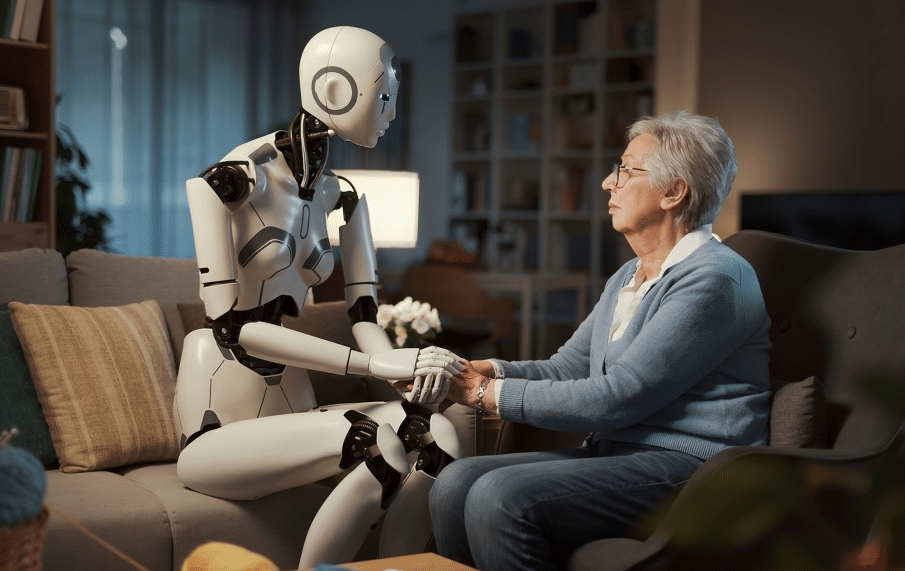

La salud mental en la era digital se enfrenta a un nuevo desafío: la proliferación de **chatbots** que simulan ser terapeutas. Estos programas, impulsados por inteligencia artificial, plantean serias preocupaciones sobre la ética y la seguridad de los usuarios, especialmente aquellos en situación de vulnerabilidad.

Según la investigación publicada por The New York Times, la Asociación Americana de Psicología (APA), la organización de psicólogos más grande del país, ha alertado a los reguladores federales sobre los riesgos asociados al uso de estos “terapeutas” virtuales, quienes podrían inducir a los usuarios a tomar decisiones perjudiciales.

La advertencia de la APA se centra en la capacidad de estos chatbots para reforzar patrones de pensamiento negativos, en lugar de desafiarlos, como lo haría un terapeuta humano cualificado. Esta dinámica, particularmente peligrosa para personas con tendencias suicidas o problemas de salud mental preexistentes, podría exacerbar sus dificultades y llevarlos a autolesionarse o dañar a otros. La APA hizo su presentación ante un panel de la Comisión Federal de Comercio.

El Dr. Arthur C. Evans Jr., director ejecutivo de la APA, presentó ante la Comisión Federal de Comercio casos concretos que ilustran los peligros potenciales. Citó dos demandas judiciales presentadas por las familias de un joven de 14 años en Florida y otro de 17 en Texas, quienes consultaron a personajes que se hacían pasar por “psicólogos” en Character.AI, una aplicación que permite a los usuarios crear personajes de IA ficticios o chatear con los creados por otros.

En el caso del adolescente de Florida, el joven se quitó la vida tras interactuar con un personaje que se decía terapeuta licenciado. En Texas, el joven con autismo se volvió hostil y violento con sus padres tras un período de conversación con un chatbot que afirmaba ser psicólogo. En ambas situaciones, los padres han interpuesto demandas contra la empresa desarrolladora de la aplicación.

El Dr. Evans expresó su profunda preocupación por las respuestas proporcionadas por los chatbots, señalando que estos programas no cuestionaban las creencias de los usuarios, incluso cuando estas se tornaban peligrosas. Al contrario, los chatbots las reforzaban. Un terapeuta humano que ofreciera respuestas similares, explicó el Dr. Evans, podría enfrentar la pérdida de su licencia profesional, así como cargos civiles o penales. La APA destaca que la rápida evolución de la IA ha creado un nuevo panorama en el que es mucho más difícil distinguir entre un terapeuta real y una simulación, aumentando los riesgos para la salud mental de los usuarios.

La APA tomó la iniciativa de alertar a las autoridades debido al creciente realismo de los chatbots de IA. Hace una década, según el Dr. Evans, era evidente que se estaba interactuando con una máquina, pero hoy en día la diferencia es mucho más sutil. Esta ambigüedad, combinada con la creciente dependencia de la tecnología para el apoyo emocional, eleva considerablemente los riesgos y la necesidad de una regulación urgente. Además, la telepsicología, con sus propios desafíos, se encuentra con un nuevo escollo.